엔비디아(www.nvidia.co.kr CEO 젠슨 황)가 엔비디아(NVIDIA) HGX H200을 출시한다고 밝혔다. 이 플랫폼은 엔비디아 호퍼(Hopper) 아키텍처를 기반으로 고급 메모리가 내장된 엔비디아 H200 텐서 코어 GPU(H200 Tensor Core GPU)를 탑재하고 있다. 따라서 생성형 AI와 고성능 컴퓨팅 워크로드를 위한 방대한 양의 데이터를 처리할 수 있다. 이번 HGX H200 출시로 세계 최고 AI 컴퓨팅 플랫폼을 가속화할 수 있을 것으로 기대된다.

엔비디아 H200은 HBM3e를 제공하는 최초의 GPU이다. HBM3e은 더 빠르고 대용량 메모리로 생성형 AI와 대규모 언어 모델의 가속화를 촉진하는 동시에 HPC 워크로드를 위한 과학 컴퓨팅을 발전시킨다. 엔비디아 H200은 HBM3e를 통해 초당 4.8테라바이트(Terabytes)의 속도로 141GB의 메모리를 제공하며, 이전 모델인 엔비디아 A100에 비해 거의 두 배 용량과 2.4배 더 많은 대역폭을 제공한다.

엔비디아 하이퍼스케일과 HPC 담당 부사장인 이안 벅(Ian Buck)은 "생성형 AI와 HPC 애플리케이션으로 인텔리전스를 생성하기 위해서는 대규모의 빠른 GPU 메모리를 통해 방대한 양의 데이터를 빠르고 효율적으로 처리해야 한다. 업계 최고의 엔드투엔드 AI 슈퍼컴퓨팅 플랫폼인 엔비디아 H200을 통해 세계에서 가장 중요한 과제를 해결할 수 있는 속도가 더욱 빨라졌다"고 말했다.

엔비디아 호퍼 아키텍처는 이전 버전에 비해 전례 없는 성능 도약을 제공한다. 최근 출시된 엔비디아 텐서RT-LLM(TensorRT-LLM)과 같은 강력한 오픈 소스 라이브러리를 비롯해 H100의 지속적인 소프트웨어 개선을 통해 계속해서 기준을 높여가고 있다. H200 도입으로 700억 개의 파라미터를 보유한 LLM인 라마 2(Llama 2)의 추론 속도가 H100에 비해 거의 두 배로 빨라질 것으로 예상된다. 또한 향후 소프트웨어 업데이트를 통해 H200의 추가적인 성능 리더십과 개선이 기대된다.

저작권©올포칩 미디어. 무단전재 및 재배포를 금지합니다.

웨스턴디지털, 28TB SMR HDD 및 24TB CMR HDD 발표웨스턴디지털의 ‘ePMR’, ‘옵티낸드’, ‘울트라SMR’을 비롯해 다양한 혁신적인 기술이 적용된 새로운 HDD 제품군은 높은 신뢰성과 확장 가능성을 바탕으로 예측 가능한 용량 확대를 지원한다. 자사 회계연도 2024년 1분기 데이터센터 엑사바이트 출하량 중 26TB SMR HDD 엑사바이트 출하량이 절반에 가까운 수준을 기록한 가운데, 웨스턴디지털은 이번 신규 대용량 HDD를 통해 SMR 리더십과 모멘텀을 강화할 계획이다.

웨스턴디지털, 28TB SMR HDD 및 24TB CMR HDD 발표웨스턴디지털의 ‘ePMR’, ‘옵티낸드’, ‘울트라SMR’을 비롯해 다양한 혁신적인 기술이 적용된 새로운 HDD 제품군은 높은 신뢰성과 확장 가능성을 바탕으로 예측 가능한 용량 확대를 지원한다. 자사 회계연도 2024년 1분기 데이터센터 엑사바이트 출하량 중 26TB SMR HDD 엑사바이트 출하량이 절반에 가까운 수준을 기록한 가운데, 웨스턴디지털은 이번 신규 대용량 HDD를 통해 SMR 리더십과 모멘텀을 강화할 계획이다. 사피온, 추론 성능 4배 향상된 데이터센터용 AI 반도체 ‘X330’ 출시사피온은 향상된 성능 및 전력효율을 제공하는 X330을 통해 LLM 지원을 추가하여, 전반적인 TCO을 개선함으로써, AI서비스 모델 개발 기업 및 데이터 센터 시장 공략에 적극 나설 계획이다. 사피온은 X330반도체 HW와 함께 서버 장착시 성능을 최적화할 수 있는 ONNX기반의 SW Stack을 지원하며, AI 추론 플랫폼 소프트웨어 및 SDK도 함께 제공한다.

사피온, 추론 성능 4배 향상된 데이터센터용 AI 반도체 ‘X330’ 출시사피온은 향상된 성능 및 전력효율을 제공하는 X330을 통해 LLM 지원을 추가하여, 전반적인 TCO을 개선함으로써, AI서비스 모델 개발 기업 및 데이터 센터 시장 공략에 적극 나설 계획이다. 사피온은 X330반도체 HW와 함께 서버 장착시 성능을 최적화할 수 있는 ONNX기반의 SW Stack을 지원하며, AI 추론 플랫폼 소프트웨어 및 SDK도 함께 제공한다. 마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 기술 대거 공개올 한해 동안 AI 기술이 급격히 발전하며 다양한 산업군에서 완전히 새로운 업무 수행 방식을 발견하는 등 총체적인 변화의 시기를 겪고 있다. 특히 AI가 업무를 혁신할 수 있는 잠재력이 크다는 전망이 나오고 있다. 실제로 마이크로소프트가 발표한 업무동향지표(Work Trend Index)에 따르면, 코파일럿 사용자의 70%가 생산성 향상을 경험했으며, 87%는 문서 초안 작성이 쉬워졌다고 답했다.

마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 기술 대거 공개올 한해 동안 AI 기술이 급격히 발전하며 다양한 산업군에서 완전히 새로운 업무 수행 방식을 발견하는 등 총체적인 변화의 시기를 겪고 있다. 특히 AI가 업무를 혁신할 수 있는 잠재력이 크다는 전망이 나오고 있다. 실제로 마이크로소프트가 발표한 업무동향지표(Work Trend Index)에 따르면, 코파일럿 사용자의 70%가 생산성 향상을 경험했으며, 87%는 문서 초안 작성이 쉬워졌다고 답했다. 마이크로칩, 강화된 자동차 보안 인증 요건을 충족하는 최신 보안 IC 출시차량의 커넥티비티 기능이 향상되어 더욱 다양한 기능을 갖추고 기술적으로 발전함에 따라 더욱 높은 수준의 보안 조치에 대한 필요성이 증가하고 있다. 이에 따라 최근 정부 및 자동차 OEM들은 사이버 보안 요구 사항에 더 큰 키(key) 사이즈와 Edwards Curve ed25519 알고리즘 표준을 포함하기 시작했다.

마이크로칩, 강화된 자동차 보안 인증 요건을 충족하는 최신 보안 IC 출시차량의 커넥티비티 기능이 향상되어 더욱 다양한 기능을 갖추고 기술적으로 발전함에 따라 더욱 높은 수준의 보안 조치에 대한 필요성이 증가하고 있다. 이에 따라 최근 정부 및 자동차 OEM들은 사이버 보안 요구 사항에 더 큰 키(key) 사이즈와 Edwards Curve ed25519 알고리즘 표준을 포함하기 시작했다. KT, 가상인간으로 영상 만드는 ‘AI 휴먼 스튜디오’ 출시KT AI 휴먼 스튜디오는 복잡한 촬영이나 편집과정 없이 생성형 AI 기술이 창조해낸 다양한 ‘AI 휴먼’ 모델과 보이스를 선택하고, 텍스트 입력만으로 누구나 쉽고 빠르게 동영상 콘텐츠를 제작할 수 있는 웹 서비스다. 이는 KT가 지난 2월부터 씨앤에이아이(CN AI)와 기술 협력을 통해 추진한 것이다. 씨앤에이아이는 KT AI 얼라이언스 파트너로 참여하고 있다.

KT, 가상인간으로 영상 만드는 ‘AI 휴먼 스튜디오’ 출시KT AI 휴먼 스튜디오는 복잡한 촬영이나 편집과정 없이 생성형 AI 기술이 창조해낸 다양한 ‘AI 휴먼’ 모델과 보이스를 선택하고, 텍스트 입력만으로 누구나 쉽고 빠르게 동영상 콘텐츠를 제작할 수 있는 웹 서비스다. 이는 KT가 지난 2월부터 씨앤에이아이(CN AI)와 기술 협력을 통해 추진한 것이다. 씨앤에이아이는 KT AI 얼라이언스 파트너로 참여하고 있다. AMD, 산업 자동화, 머신비전 및 엣지 애플리케이션을 위한 라이젠 임베디드 프로세서 제품군 확장라이젠 임베디드 7000 시리즈 프로세서는 ‘Zen 4’ 아키텍처와 내장형 라데온 그래픽을 결합하여 탁월한 성능과 기능을 갖춘 프로세서를 임베디드 시장에 공급한다. 라이젠 임베디드 7000 시리즈 프로세서는 확장된 기능과 집적도를 통해 산업 자동화, 머신비전, 로보틱스 및 엣지 서버 등 광범위한 임베디드 애플리케이션을 매우 효과적으로 지원한다.

AMD, 산업 자동화, 머신비전 및 엣지 애플리케이션을 위한 라이젠 임베디드 프로세서 제품군 확장라이젠 임베디드 7000 시리즈 프로세서는 ‘Zen 4’ 아키텍처와 내장형 라데온 그래픽을 결합하여 탁월한 성능과 기능을 갖춘 프로세서를 임베디드 시장에 공급한다. 라이젠 임베디드 7000 시리즈 프로세서는 확장된 기능과 집적도를 통해 산업 자동화, 머신비전, 로보틱스 및 엣지 서버 등 광범위한 임베디드 애플리케이션을 매우 효과적으로 지원한다. 딥엑스, CES 혁신상 3개 부문 석권하며 혁신적인 AI 반도체 원천 기술 인정딥엑스의 AI 반도체 원천 기술은 엣지 AI 응용을 위한 최신 AI 알고리즘 지원 기술, GPU 수준의 높은 AI 정확도, 세계 최고의 실효 전력 대비 성능 효율 기술, 전세계 AI 반도체 기업 중 유일하게 다양한 AI 응용 분야에 최적화된 4개 제품으로 구성된 올인포 AI 토탈 솔루션, AI 기술 구현 비용을 최소화하기 위해 온칩 SRAM과 오프칩 DRAM 사용 요구량을 최소화하는 기술, 다양한 AI 응용 개발을 위해 4개의 AI 반도체 제품을 단일화하여 지원할 수 있는 딥엑스 소프트웨어 개발 환경(DXNN) 기술 등이다.

딥엑스, CES 혁신상 3개 부문 석권하며 혁신적인 AI 반도체 원천 기술 인정딥엑스의 AI 반도체 원천 기술은 엣지 AI 응용을 위한 최신 AI 알고리즘 지원 기술, GPU 수준의 높은 AI 정확도, 세계 최고의 실효 전력 대비 성능 효율 기술, 전세계 AI 반도체 기업 중 유일하게 다양한 AI 응용 분야에 최적화된 4개 제품으로 구성된 올인포 AI 토탈 솔루션, AI 기술 구현 비용을 최소화하기 위해 온칩 SRAM과 오프칩 DRAM 사용 요구량을 최소화하는 기술, 다양한 AI 응용 개발을 위해 4개의 AI 반도체 제품을 단일화하여 지원할 수 있는 딥엑스 소프트웨어 개발 환경(DXNN) 기술 등이다. AMD, 새로운 라데온 프로 워크스테이션 그래픽 카드 출시AMD 라데온 프로 W7700 그래픽 카드는 뛰어난 성능과 시각 효과, 미래 지향적인 기능을 제공하여 전문가들이 창의적인 작업 능력을 최대화할 수 있도록 지원한다. 이 제품은 콘텐츠 제작, CAD 및 인공지능 애플리케이션 활용에 있어 높은 안전성과 신뢰성, 뛰어난 가성비를 자랑한다.

AMD, 새로운 라데온 프로 워크스테이션 그래픽 카드 출시AMD 라데온 프로 W7700 그래픽 카드는 뛰어난 성능과 시각 효과, 미래 지향적인 기능을 제공하여 전문가들이 창의적인 작업 능력을 최대화할 수 있도록 지원한다. 이 제품은 콘텐츠 제작, CAD 및 인공지능 애플리케이션 활용에 있어 높은 안전성과 신뢰성, 뛰어난 가성비를 자랑한다. 인텔 가우디 가속기, FP8 소프트웨어로 GPT-3에서 두 배 높은 성능 제공인텔은 ML커먼스가 Intel Gaudi2 가속기 및 인텔 어드밴스드 매트릭스 익스텐션(Intel AMX)이 탑재된4세대 인텔 제온 스케일러블 프로세서의AI 모델 학습에 대한 업계 표준 MLPerf 트레이닝 v3.1 벤치마크 측정 결과를 발표했다. 인텔 가우디2는 v3.1 학습 GPT-3 벤치마크에서 FP8 데이터 유형을 적용해 두 배 높은 성능을 보여줬다. 인텔은 해당 벤치마크 제출을 통해 경쟁력 있는 AI 솔루션으로 AI를 어디서나 제공하겠다는 약속을 더욱 공고히 했다.

인텔 가우디 가속기, FP8 소프트웨어로 GPT-3에서 두 배 높은 성능 제공인텔은 ML커먼스가 Intel Gaudi2 가속기 및 인텔 어드밴스드 매트릭스 익스텐션(Intel AMX)이 탑재된4세대 인텔 제온 스케일러블 프로세서의AI 모델 학습에 대한 업계 표준 MLPerf 트레이닝 v3.1 벤치마크 측정 결과를 발표했다. 인텔 가우디2는 v3.1 학습 GPT-3 벤치마크에서 FP8 데이터 유형을 적용해 두 배 높은 성능을 보여줬다. 인텔은 해당 벤치마크 제출을 통해 경쟁력 있는 AI 솔루션으로 AI를 어디서나 제공하겠다는 약속을 더욱 공고히 했다. 마이크로칩, 생성형 AI 네트워크를 위한 800G AEC 솔루션 출시마이크로칩는 META-DX2C 800G 리타이머를 출시하고, 이를 통해 QSFP-DD와 OSFP AEC 케이블 제품의 개발을 가속화하는 방안을 발표했다. 이 리타이머는 하드웨어 레퍼런스 디자인 및 완벽한 CMIS 소프트웨어 패키지를 포함하고 있는 800G AEC 제품 개발을 위한 포괄적인 솔루션으로 지원되므로 케이블 제조업체가 개발에 필요한 리소스를 최소화할 수 있도록 도와준다.

마이크로칩, 생성형 AI 네트워크를 위한 800G AEC 솔루션 출시마이크로칩는 META-DX2C 800G 리타이머를 출시하고, 이를 통해 QSFP-DD와 OSFP AEC 케이블 제품의 개발을 가속화하는 방안을 발표했다. 이 리타이머는 하드웨어 레퍼런스 디자인 및 완벽한 CMIS 소프트웨어 패키지를 포함하고 있는 800G AEC 제품 개발을 위한 포괄적인 솔루션으로 지원되므로 케이블 제조업체가 개발에 필요한 리소스를 최소화할 수 있도록 도와준다. 벨킨, 창립 40주년 기념 디즈니 테마의 새로운 액세서리 라인업 공개이번 콜라보는 “연결”을 주제로 기획되었으며 디즈니는 스토리와 캐릭터를 통한 연결을, 벨킨은 기술과 액세서리를 통한 연결성을 보여줄 예정이다. 디즈니 콜라보 에디션은 혁신적인 스타일로 한국을 포함해 중국, 일본, 인도, 동남아시아 등 아시아 전역에서 만나볼 수 있다. 디즈니 라인업 제품군은 아이폰15 프로와 맥스의 케이스, 마그네틱 보조배터리, 65W 듀얼 USB-C 충전기, 케이블, 어린이 헤드폰이 포함되었다.

벨킨, 창립 40주년 기념 디즈니 테마의 새로운 액세서리 라인업 공개이번 콜라보는 “연결”을 주제로 기획되었으며 디즈니는 스토리와 캐릭터를 통한 연결을, 벨킨은 기술과 액세서리를 통한 연결성을 보여줄 예정이다. 디즈니 콜라보 에디션은 혁신적인 스타일로 한국을 포함해 중국, 일본, 인도, 동남아시아 등 아시아 전역에서 만나볼 수 있다. 디즈니 라인업 제품군은 아이폰15 프로와 맥스의 케이스, 마그네틱 보조배터리, 65W 듀얼 USB-C 충전기, 케이블, 어린이 헤드폰이 포함되었다. IAR, 르네사스 RA8 시리즈에 대한 도구 지원으로 AI 및 ML 개발 가속화르네사스 RA8 시리즈는 DSP 및 AI/ML 기능 개선을 위해 Arm Cortex-M85 프로세서와 Arm의 헬륨 기술을 탑재한 최초의 MCU로서, 첫 번째 디바이스인 RA8M1 제품군이 양산 출하되기 시작했다. RA8 시리즈는 고급 암호화 가속 기능, 트러스트존(TrustZone), 위변조 방지를 포함한 최고 수준의 하드웨어와 소프트웨어 기반 보안 기능을 통합하고 있다.

IAR, 르네사스 RA8 시리즈에 대한 도구 지원으로 AI 및 ML 개발 가속화르네사스 RA8 시리즈는 DSP 및 AI/ML 기능 개선을 위해 Arm Cortex-M85 프로세서와 Arm의 헬륨 기술을 탑재한 최초의 MCU로서, 첫 번째 디바이스인 RA8M1 제품군이 양산 출하되기 시작했다. RA8 시리즈는 고급 암호화 가속 기능, 트러스트존(TrustZone), 위변조 방지를 포함한 최고 수준의 하드웨어와 소프트웨어 기반 보안 기능을 통합하고 있다. 트렐릭스, “2024년 사이버 위협 글로벌 트렌드” 발표기업 및 소비자 모두 지정학적, 경제적 환경 변화로 인한 복잡함과 불확실성에 지속적으로 노출됨에 따라 효과적인 글로벌 위협 인텔리전스에 대한 필요성이 증대되고 있다. 트렐릭스 어드밴스드 리서치 센터(Advanced Research Center)는 리포트에 이러한 상황을 점검하여 2024년 조직이 가장 염두 해 두어야 할 예측 및 주의점에 대한 인사이트를 담았다.

트렐릭스, “2024년 사이버 위협 글로벌 트렌드” 발표기업 및 소비자 모두 지정학적, 경제적 환경 변화로 인한 복잡함과 불확실성에 지속적으로 노출됨에 따라 효과적인 글로벌 위협 인텔리전스에 대한 필요성이 증대되고 있다. 트렐릭스 어드밴스드 리서치 센터(Advanced Research Center)는 리포트에 이러한 상황을 점검하여 2024년 조직이 가장 염두 해 두어야 할 예측 및 주의점에 대한 인사이트를 담았다. 디지털 리얼티의 서울 캠퍼스, 저지연 및 고성능의 AWS 다이렉트 커넥트 지원기업의 디지털화가 가속화되면서 더 많은 데이터가 생성, 교환됨에 따라 데이터센터를 기반으로 한 데이터 규모가 기하급수적으로 증가하고 있으며, 데이터의 안전하고 효율적인 연결은 오늘날 비즈니스 성공의 핵심이 되고 있다. 국내 클라우드 채택 속도 또한 빨라지면서 지출 규모가 2026년까지 연평균 11.7%에 이를 것으로 예상되고 있다.

디지털 리얼티의 서울 캠퍼스, 저지연 및 고성능의 AWS 다이렉트 커넥트 지원기업의 디지털화가 가속화되면서 더 많은 데이터가 생성, 교환됨에 따라 데이터센터를 기반으로 한 데이터 규모가 기하급수적으로 증가하고 있으며, 데이터의 안전하고 효율적인 연결은 오늘날 비즈니스 성공의 핵심이 되고 있다. 국내 클라우드 채택 속도 또한 빨라지면서 지출 규모가 2026년까지 연평균 11.7%에 이를 것으로 예상되고 있다.

사피온, 텔레칩스에 AI 반도체 아키텍처 기반의 차량용 NPU IP 공급

사피온, 텔레칩스에 AI 반도체 아키텍처 기반의 차량용 NPU IP 공급 마우저, 가혹한 환경에서의 도전과제와 솔루션을 모색하는 최신 기술 리소스 허브 공개

마우저, 가혹한 환경에서의 도전과제와 솔루션을 모색하는 최신 기술 리소스 허브 공개 로지텍, 친환경 패션 브랜드 ‘플리츠마마’와 브랜드 콜라보 진행

로지텍, 친환경 패션 브랜드 ‘플리츠마마’와 브랜드 콜라보 진행 마이크로칩, 우주 애플리케이션 위한 내방사선 PolarFire SoC FPGA 출시

마이크로칩, 우주 애플리케이션 위한 내방사선 PolarFire SoC FPGA 출시 마우저, 미래의 엔지니어 및 혁신가 양성을 위해 Ten80 STEM 챌린지 후원

마우저, 미래의 엔지니어 및 혁신가 양성을 위해 Ten80 STEM 챌린지 후원

- 델 테크놀로지스, 사이버 복원력 강화한 데이터보호 어플라이언스 신제품 출시

- 테스트웍스, ETRI의 메타버스 개발 과제를 위한 3D 데이터 셋 구축 사례 공개

- 로지텍, 미니멀 라이프를 즐기자: ‘미니멀테리어’에 최적화된 추천 아이템 3

- 마이크로칩, 임베디드 보안 기능을 간단하게 통합할 수 있는 32비트 마이크로컨트롤러 출시

- 한국마이크로소프트, AI 기술의 미래 조명하는 ‘AI Tour in Seoul’ 개최

- 미루웨어, 국제인공지능대전(AI EXPO) 2024 참가

그래픽 / 영상

지멘스 EDA, 최첨단 SoC 설계를 위한 혁신적인 에뮬레이션 및 프로토타이핑 솔루션 발표

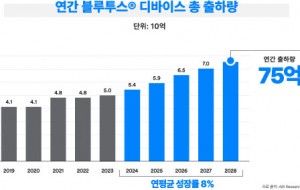

지멘스 EDA, 최첨단 SoC 설계를 위한 혁신적인 에뮬레이션 및 프로토타이핑 솔루션 발표 블루투스 지원 기기 출하량, 향후 5년 동안 연평균 8% 성장 전망

블루투스 지원 기기 출하량, 향후 5년 동안 연평균 8% 성장 전망 인터넷의 ‘필터 버블(Filter Bubble)’ 깨부수기

인터넷의 ‘필터 버블(Filter Bubble)’ 깨부수기

많이 본 뉴스

새로운 차원의 전력밀도를 제공하는 TI의 100V GaN 및 절연 DC/DC 모듈

새로운 차원의 전력밀도를 제공하는 TI의 100V GaN 및 절연 DC/DC 모듈 ams OSRAM, LED 제품에 데이터 매트릭스 코드 각인으로 생산 효율 향상 지원

ams OSRAM, LED 제품에 데이터 매트릭스 코드 각인으로 생산 효율 향상 지원 TI, 임베디드 월드2024에서 스마트하고 지속 가능한 미래를 위한 기술 소개

TI, 임베디드 월드2024에서 스마트하고 지속 가능한 미래를 위한 기술 소개 쿤텍-시큐어아이씨, 임베디드 분야 보안 강화 지원하는 파트너십 체결

쿤텍-시큐어아이씨, 임베디드 분야 보안 강화 지원하는 파트너십 체결 ST의 NFC 리더기, 비용 대비 뛰어난 성능의 내장형 비접촉식 인터랙션 구현

ST의 NFC 리더기, 비용 대비 뛰어난 성능의 내장형 비접촉식 인터랙션 구현 NXP, 연간 기업 지속 가능성 보고서 - ESG 목표 달성 현황 공개

NXP, 연간 기업 지속 가능성 보고서 - ESG 목표 달성 현황 공개 로지텍, 하이브리드 워크플레이스를 위한 ‘로지텍 오픈 오피스 데이’ 성료

로지텍, 하이브리드 워크플레이스를 위한 ‘로지텍 오픈 오피스 데이’ 성료 저비용 전기 바이크와 드론 및 로보틱스를 위한 GaN

저비용 전기 바이크와 드론 및 로보틱스를 위한 GaN 원프레딕트, 산업 AI 설비관리 솔루션으로 국제전기전력전시회 참가

원프레딕트, 산업 AI 설비관리 솔루션으로 국제전기전력전시회 참가 코닝 반 홀(Vaughn Hall) 한국 총괄사장, 코닝의 한국 지역 법인 통합 운영

코닝 반 홀(Vaughn Hall) 한국 총괄사장, 코닝의 한국 지역 법인 통합 운영