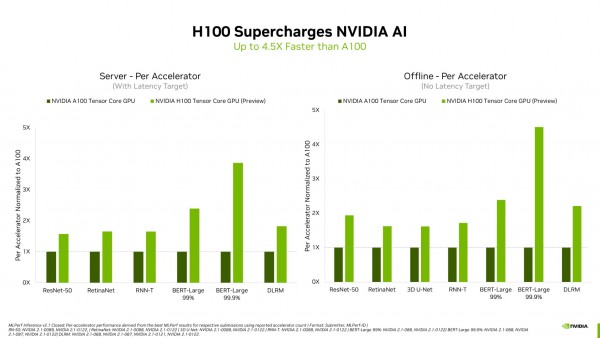

엔비디아(www.nvidia.co.kr CEO 젠슨 황)가 MLPerf 업계 표준 AI 벤치마크에서 엔비디아 H100 텐서 코어(NVIDIA H100 Tensor Core) GPU를 발표했다. 이는 모든 워크로드에 대한 추론에서 세계 기록을 세웠으며, 이전 세대 GPU보다 최대 4.5배 더 높은 성능을 제공한다. 이 결과는 호퍼(Hopper)가 고급 AI 모델에서 최고의 성능을 요구하는 사용자를 위한 프리미엄 선택임을 보여준다.

더불어 AI 기반 로보틱스를 위한 엔비디아 A100 텐서 코어 GPU와 엔비디아 젯슨 AGX 오린(Jetson AGX Orin) 모듈은 이미지 및 음성 인식, 자연어 처리 및 추천 시스템과 같은 모든 MLPerf 테스트에서 전반적인 리더십 추론 성능을 지속적으로 제공했다.

호퍼로 알려진 H100은 라운드의 모든 6개 신경망에서 가속기 당 성능 기준을 높였다. 별도의 서버와 오프라인 시나리오에서 처리량과 속도 모두에서 리더십을 보였다.

엔비디아 H100 GPU는 데이터 센터 범주의 모든 워크로드에 대해 새로운 최고점을 설정한다.

엔비디아 호퍼 아키텍처는 MLPerf 결과에서 전반적인 리더십을 계속 제공하는 엔비디아 암페어(Ampere) 아키텍처 GPU보다 최대 4.5배 더 높은 성능을 제공한다. 부분적으로는 트랜스포머 엔진 덕분에 호퍼는 자연어 처리를 위한 인기 있는 BERT 모델에서 탁월했다. 이는 MLPerf AI 모델 중 가장 크고 성능이 필요한 모델 중 하나이다. 이러한 추론 벤치마크는 올해 말에 출시될 H100 GPU의 첫 공개 데모이다. H100 GPU는 훈련을 위해 향후 MLPerf 라운드에 참여할 예정이다.

A100 GPU의 리더십

현재 주요 클라우드 서비스 제공업체와 시스템 제조업체에서 제공하는 엔비디아 A100 GPU는 최신 테스트에서 AI 추론의 주류 성능에서 전반적인 리더십을 계속 보여줬다. A100 GPU는 데이터 센터, 엣지 컴퓨팅 범주 및 시나리오에서 제출된 것보다 더 많은 테스트를 통과했다. A100은 지난 6월에 MLPerf 교육 벤치마크에서도 전반적인 리더십을 발휘해 AI 워크플로 전반에 걸쳐 능력을 입증했다.

2020년 7월 MLPerf에서 데뷔한 A100 GPU는 엔비디아 AI 소프트웨어의 지속적인 개선 덕분에 성능이 6배 향상됐다. 엔비디아 AI는 데이터 센터 및 엣지 컴퓨팅에서 모든 MLPerf 추론 워크로드 및 시나리오를 실행하는 유일한 플랫폼이다.

다양한 성능이 필요한 사용자

엔비디아 GPU는 모든 주요 AI 모델에서 최고의 성능을 제공하는 능력으로 사용자를 돕는다. 실제 애플리케이션은 일반적으로 다양한 종류의 많은 신경망을 사용한다. 예를 들어, AI 애플리케이션은 사용자의 음성 요청을 이해하고, 이미지를 분류하고, 추천한 다음 인간 목소리로 음성 메시지로 응답을 전달해야 할 수 있다. 이때 각 단계마다 다른 유형의 AI 모델이 필요하다.

MLPerf 벤치마크는 컴퓨터 비전, 자연어 처리, 추천 시스템, 음성 인식 등 널리 사용되는 AI 워크로드와 시나리오를 다룬다. 테스트를 통해 사용자는 신뢰할 수 있고 유연하게 구현할 수 있는 성능을 얻을 수 있다.

사용자는 정보에 입각한 구매 결정을 내리기 위해 테스트가 투명하고 객관적인 MLPerf 결과에 의존한다. 벤치마크는 아마존(Amazon), Arm, 바이두(Baidu), 구글(Google), 하버드(Harvard), 인텔(Intel), 메타(Meta), 마이크로소프트(Microsoft), 스탠포드(Stanford) 및 토론토 대학교(University of Toronto)를 포함한 광범위한 그룹의 지원을 받는다.

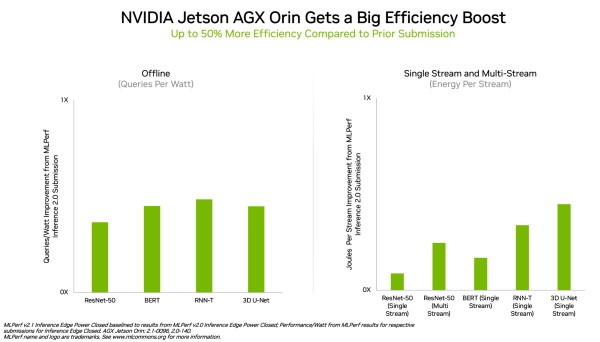

엣지에서 리드하는 오린

엣지 컴퓨팅에서 엔비디아 오린은 모든 MLPerf 벤치마크를 실행해 다른 어떤 저전력 시스템 온 칩(SoC)보다 더 많은 테스트를 통과했다. 그리고 지난 4월 MLPerf에서 처음으로 선보인 것보다 에너지 효율성이 최대 50% 향상됐다. 이전 라운드에서 오린은 이전 세대 젯슨 AGX 자비에(Xavier) 모듈보다 최대 5배 더 빠르게 실행됐으며, 평균 두배 더 나은 에너지 효율성을 제공했다.

오린은 엣지에서 AI 추론을 위해 에너지 효율성을 최대 50% 향상시켰다.

오린은 엔비디아 암페어 아키텍처 GPU와 강력한 Arm CPU 코어 클러스터를 단일 칩에 통합한다. 현재 엔비디아 젯슨 AGX 오린 개발자 키트와 로보틱스 및 자율 시스템용 생산 모듈에서 사용할 수 있으며, 자율주행 차량(NVIDIA Hyperion), 의료 기기(Clara Holoscan) 및 로보틱스(Isaac) 플랫폼을 포함한 전체 엔비디아 AI 소프트웨어 스택을 지원한다.

광범위한 엔비디아 AI 생태계

MLPerf 결과에 따르면 엔비디아 AI는 머신 러닝 업계에서 가장 광범위한 생태계의 지원을 받고 있다. 이번 라운드에서 70개 이상의 제출물이 엔비디아 플랫폼에서 실행됐다. 예를 들어 마이크로소프트 애저(Microsoft Azure)는 클라우드 서비스에서 엔비디아 AI를 실행한 결과를 제출했다.

또한 이번 라운드에는 에이수스(ASUS), 델 테크놀로지(Dell Technologies), 후지쯔(Fujitsu), 기가바이트(GIGABYTE), 휴렛 팩커드 엔터프라이즈(Hewlett Packard Enterprise), 레노버(Lenovo) 및 슈퍼마이크로(Supermicro)를 포함한 10개의 시스템 제조업체에서 19개의 엔비디아 인증 시스템이 등장했다. 이들의 작업은 사용자가 클라우드와 자체 데이터 센터에서 실행되는 서버 모두에서 엔비디아 AI로 뛰어난 성능을 얻을 수 있음을 보여준다.

저작권©올포칩 미디어. 무단전재 및 재배포를 금지합니다.

로옴, 미세 발광을 위해 밝기 및 색의 편차를 저감한 1608 사이즈 LED 개발이 제품은 로옴의 자체 제작 소자 기술을 이용하여 2mA에서의 발광에 적합한 소자 특성을 실현함으로써 미세 발광 시의 밝기 및 색감과 같은 시각적 편차를 저감한 LED이다. 일반적인 20mA 사양의 LED를 저전류로 발광시키면, 제품에 따라 밝기의 편차나 색감의 변화가 발생하게 된다.

로옴, 미세 발광을 위해 밝기 및 색의 편차를 저감한 1608 사이즈 LED 개발이 제품은 로옴의 자체 제작 소자 기술을 이용하여 2mA에서의 발광에 적합한 소자 특성을 실현함으로써 미세 발광 시의 밝기 및 색감과 같은 시각적 편차를 저감한 LED이다. 일반적인 20mA 사양의 LED를 저전류로 발광시키면, 제품에 따라 밝기의 편차나 색감의 변화가 발생하게 된다. Arm, 컴퓨팅 인프라를 새롭게 정의하는 차세대 네오버스 플랫폼 발표Arm은 하이퍼스케일 및 HPC 고객의 요구사항에 대응하고 더 많은 전력과 공간을 소모하지 않으면서도 클라우드 워크로드 성능을 더욱 강화하기 위해 최신 V시리즈 코어와 Arm CMN-700 메시 인터커넥트를 특징으로 하는 Arm네오버스 V2 플랫폼(디미터)을 공개했다. 네오버스 V2는 클라우드 및 HPC 워크로드에 대해 업계 최고의 정수 성능을 제공하며, Armv9 아키텍처의 향상된 보안 기능을 갖추고 있다.

Arm, 컴퓨팅 인프라를 새롭게 정의하는 차세대 네오버스 플랫폼 발표Arm은 하이퍼스케일 및 HPC 고객의 요구사항에 대응하고 더 많은 전력과 공간을 소모하지 않으면서도 클라우드 워크로드 성능을 더욱 강화하기 위해 최신 V시리즈 코어와 Arm CMN-700 메시 인터커넥트를 특징으로 하는 Arm네오버스 V2 플랫폼(디미터)을 공개했다. 네오버스 V2는 클라우드 및 HPC 워크로드에 대해 업계 최고의 정수 성능을 제공하며, Armv9 아키텍처의 향상된 보안 기능을 갖추고 있다. 더큐티컴퍼니, 신규 고객 위한 맞춤형 컨설팅 서비스 제공더큐티컴퍼니의 입문 고객을 위한 서비스 패키지인 ’Qt 스타터 팩’은 다수의 애플리케이션 개발 경험을 갖춘 전문가로 구성된 ’Qt 프로페셔널 서비스’ 팀이 지원한다. ’Qt 스타터 팩’은 Qt애플리케이션 개발을 위한 기본 프로그래밍, 임베디드 환경에서의 효과적인 애플리케이션 개발, 애플리케이션 성능 프로파일링 및 최적화, 기초적인 3D UI 구현 등을 포함한 기술 교육과 고객 맞춤형 워크샵, 컨설팅 서비스를 함께 제공한다.

더큐티컴퍼니, 신규 고객 위한 맞춤형 컨설팅 서비스 제공더큐티컴퍼니의 입문 고객을 위한 서비스 패키지인 ’Qt 스타터 팩’은 다수의 애플리케이션 개발 경험을 갖춘 전문가로 구성된 ’Qt 프로페셔널 서비스’ 팀이 지원한다. ’Qt 스타터 팩’은 Qt애플리케이션 개발을 위한 기본 프로그래밍, 임베디드 환경에서의 효과적인 애플리케이션 개발, 애플리케이션 성능 프로파일링 및 최적화, 기초적인 3D UI 구현 등을 포함한 기술 교육과 고객 맞춤형 워크샵, 컨설팅 서비스를 함께 제공한다. 피커링 인터페이스, 협업 및 필수 프로젝트 관리, 보안 기능이 추가된 향상된 케이블 디자인 툴 발표피커링 CDT는 엔지니어들이 테스트 시스템 설계시 케이블 연결 솔루션을 쉽게 설계, 생성할 수 있도록 돕기 위하여 6년 전에 발표되었다. 최신판은 원래의 것과 비슷해 보이지만, 사용자들의 의견을 반영한 많은 새로운 기능을 갖고 있다. 이 툴의 새로운 기능은 프로젝트 관리이며, 주요 목적은 프로젝트 폴더 구조에서 설계를 관리하는 것이다.

피커링 인터페이스, 협업 및 필수 프로젝트 관리, 보안 기능이 추가된 향상된 케이블 디자인 툴 발표피커링 CDT는 엔지니어들이 테스트 시스템 설계시 케이블 연결 솔루션을 쉽게 설계, 생성할 수 있도록 돕기 위하여 6년 전에 발표되었다. 최신판은 원래의 것과 비슷해 보이지만, 사용자들의 의견을 반영한 많은 새로운 기능을 갖고 있다. 이 툴의 새로운 기능은 프로젝트 관리이며, 주요 목적은 프로젝트 폴더 구조에서 설계를 관리하는 것이다. 포티넷, 셀프-러닝 AI 기술 기반 비정상 네트워크 행위 탐지 및 대응 솔루션 출시FortiNDR은 셀프-러닝 AI 기능, 머신 러닝, 고차원 분석 기술을 통해 기업의 정상적인 네트워크 활동에 대한 정교한 기준을 바탕으로 사이버 캠페인 현상을 탐지하며, IP/포트, 프로토콜/동작, 공격 대상, 패킷 크기, 트래픽 발생 위치, 디바이스 유형 등을 기준으로 프로파일링을 실행한다. 이를 통해 기업들은 일반적으로 알려진 위협 정보가 아닌, 전세계적으로 잘 알려진 위협이나 악성코드 구성요소 정보를 활용해 보안 침해 사고를 파악함으로써 조기에 위협 탐지가 가능하다.

포티넷, 셀프-러닝 AI 기술 기반 비정상 네트워크 행위 탐지 및 대응 솔루션 출시FortiNDR은 셀프-러닝 AI 기능, 머신 러닝, 고차원 분석 기술을 통해 기업의 정상적인 네트워크 활동에 대한 정교한 기준을 바탕으로 사이버 캠페인 현상을 탐지하며, IP/포트, 프로토콜/동작, 공격 대상, 패킷 크기, 트래픽 발생 위치, 디바이스 유형 등을 기준으로 프로파일링을 실행한다. 이를 통해 기업들은 일반적으로 알려진 위협 정보가 아닌, 전세계적으로 잘 알려진 위협이나 악성코드 구성요소 정보를 활용해 보안 침해 사고를 파악함으로써 조기에 위협 탐지가 가능하다. 힐셔 신임 CTO 선임, IIoT 전략의 중요성 강화힐셔는 토마스 라우치(Thomas Rauch)를 신임 최고 기술 책임자(CTO)로 맞이하였다. 라우치는 주로 하드웨어, 칩, 소프트웨어 및 클라우드 분야를 담당하며, 전문 기술 엔지니어로써 산업용 사물인터넷(IIoT)용 자체 전략 구현을 위해 힐셔 본사가 위치하고 있는 독일 하터샤임(Hattersheim)의 산업용 통신 전문 인력도 지원할 예정이다.

힐셔 신임 CTO 선임, IIoT 전략의 중요성 강화힐셔는 토마스 라우치(Thomas Rauch)를 신임 최고 기술 책임자(CTO)로 맞이하였다. 라우치는 주로 하드웨어, 칩, 소프트웨어 및 클라우드 분야를 담당하며, 전문 기술 엔지니어로써 산업용 사물인터넷(IIoT)용 자체 전략 구현을 위해 힐셔 본사가 위치하고 있는 독일 하터샤임(Hattersheim)의 산업용 통신 전문 인력도 지원할 예정이다. 실리콘랩스, ‘Works With’ 개발자 컨퍼런스에서 IoT의 미래상 제시실리콘랩스는 매터(Matter), 아마존 사이드워크(Amazon Sidewalk), 와이선(Wi-SUN), 와이파이 6(Wi-Fi 6) 등 사물 인터넷(IoT) 기술의 혁신과 트렌드를 발전시켜 나가기 위해 멀티 프로토콜을 지원하고 상호 운용성을 중시하며 강건하고 보안상 안전한 일련의 신제품들을 출시한다고 밝혔다.

실리콘랩스, ‘Works With’ 개발자 컨퍼런스에서 IoT의 미래상 제시실리콘랩스는 매터(Matter), 아마존 사이드워크(Amazon Sidewalk), 와이선(Wi-SUN), 와이파이 6(Wi-Fi 6) 등 사물 인터넷(IoT) 기술의 혁신과 트렌드를 발전시켜 나가기 위해 멀티 프로토콜을 지원하고 상호 운용성을 중시하며 강건하고 보안상 안전한 일련의 신제품들을 출시한다고 밝혔다. 마우저와 몰렉스, RF 커넥터 관련 새로운 컨텐츠 스트림 제공마우저는 몰렉스(Molex)와 RF 커넥터의 성능, 과제 및 혁신적 잠재력을 탐구하는 신규 컨텐츠 스트림을 발표했다. 이 컨텐츠 스트림에는 RF 기술에 관한 팟캐스트 에피소드, 백서, 블로그 포스트, 제품 가이드를 비롯하여 열 종류 이상의 심층 리소스가 수록되어 있다. 각 컨텐츠는 마우저와 몰렉스의 제품 정보와 바로 연결되어 디바이스 제조사들이 설계 애플리케이션에 필요한 도구에 연결될 수 있도록 해준다.

마우저와 몰렉스, RF 커넥터 관련 새로운 컨텐츠 스트림 제공마우저는 몰렉스(Molex)와 RF 커넥터의 성능, 과제 및 혁신적 잠재력을 탐구하는 신규 컨텐츠 스트림을 발표했다. 이 컨텐츠 스트림에는 RF 기술에 관한 팟캐스트 에피소드, 백서, 블로그 포스트, 제품 가이드를 비롯하여 열 종류 이상의 심층 리소스가 수록되어 있다. 각 컨텐츠는 마우저와 몰렉스의 제품 정보와 바로 연결되어 디바이스 제조사들이 설계 애플리케이션에 필요한 도구에 연결될 수 있도록 해준다.- 인텔, 브로드컴과 업계 최초로 와이파이 7 기술 데모 시연와이파이 7은 더 빠른 속도, 더 짧은 지연시간, 향상된 안정성 그리고 더 큰 용량을 요구하는 향후10년간의 새로운 무선 경험 플랫폼이다. 와이파이 7은 6GHz 스펙트럼의 최대 320MHz 대역폭 사용, 4K QAM 조정, 다중 링크 운영 기반 다중 대역폭 동시 연결, 다중 리소스 유닛 기능 기반 효율적 대역폭 활용 등의 새로운 기능들을 갖췄다.

멘로시큐리티, 무료 보안 평가 도구 ‘HEAT 체크’ 출시HEAT 체크(HEAT Check)는 조직이 HEAT 공격에 대한 취약성을 더 잘 이해할 수 있도록 간단한 모의 침투 테스트를 실행하여, 노출 평가 분석 정보를 제공하여, 랜섬웨어 탐지가 아닌 격리로 100% 근본적 보안 해결책을 제시한다. 또한 위협 행위자가 사용하는 여러 실제 HEAT 공격을 진행하여 결과치를 제공함으로써, 조직이 보안 환경을 강력하게 구축하기 위한 의사 결정을 내릴 수 있도록 지원하다.

멘로시큐리티, 무료 보안 평가 도구 ‘HEAT 체크’ 출시HEAT 체크(HEAT Check)는 조직이 HEAT 공격에 대한 취약성을 더 잘 이해할 수 있도록 간단한 모의 침투 테스트를 실행하여, 노출 평가 분석 정보를 제공하여, 랜섬웨어 탐지가 아닌 격리로 100% 근본적 보안 해결책을 제시한다. 또한 위협 행위자가 사용하는 여러 실제 HEAT 공격을 진행하여 결과치를 제공함으로써, 조직이 보안 환경을 강력하게 구축하기 위한 의사 결정을 내릴 수 있도록 지원하다. EPC, 성능 대비 비용을 최적화할 수 있는 풋프린트 호환 GaN FET 제품 출시EPC2306 GaN FET는 낮은 전도 및 스위칭 손실을 위해 매우 작은 QG, QGD, QOSS 파라미터와 함께 3.8mOhm에 불과한 초저 RDS(on)을 제공한다. 이 디바이스는 상단이 노출된 3mm x 5mm에 불과한 풋프린트로 열 성능이 향상된 QFN 패키지로 공급되며, 최고 밀도의 전력 애플리케이션을 위해 극도로 작은 솔루션 크기를 제공한다.

EPC, 성능 대비 비용을 최적화할 수 있는 풋프린트 호환 GaN FET 제품 출시EPC2306 GaN FET는 낮은 전도 및 스위칭 손실을 위해 매우 작은 QG, QGD, QOSS 파라미터와 함께 3.8mOhm에 불과한 초저 RDS(on)을 제공한다. 이 디바이스는 상단이 노출된 3mm x 5mm에 불과한 풋프린트로 열 성능이 향상된 QFN 패키지로 공급되며, 최고 밀도의 전력 애플리케이션을 위해 극도로 작은 솔루션 크기를 제공한다. 엔비디아, 지포스 RTX 구매 고객 대상 ‘마블 스파이더맨 리마스터' 제공마블 스파이더맨 리마스터는 레이 트레이싱 효과와 성능을 가속화하는 엔비디아 DLSS를 탑재했다. 지포스 RTX RT 코어 및 엔비디아 DLSS의 성능을 통해 지포스 RTX 3080, 3080 Ti, 3090, 3090 Ti는 환상적인 시각적 그래픽과 매우 부드러운 120FPS+로 울트라 프리셋(Ultra-preset) 경험을 제공한다.

엔비디아, 지포스 RTX 구매 고객 대상 ‘마블 스파이더맨 리마스터' 제공마블 스파이더맨 리마스터는 레이 트레이싱 효과와 성능을 가속화하는 엔비디아 DLSS를 탑재했다. 지포스 RTX RT 코어 및 엔비디아 DLSS의 성능을 통해 지포스 RTX 3080, 3080 Ti, 3090, 3090 Ti는 환상적인 시각적 그래픽과 매우 부드러운 120FPS+로 울트라 프리셋(Ultra-preset) 경험을 제공한다. KT, 건사협과 지하 통신시설 보호 위해 협력양 기관은 공동 안전관리와 예방을 위한 기술 개발과 시범 적용에 상호 협력하기로 이번 협약을 통해 약속했다. KT는 우선적으로 건사협 회원이 지하 통신시설 매설 정보 확인을 위한 직통 채널을 공유하고, 협약 이후 건사협의 중장비 주변 KT 지하 통신시설 여부 확인을 위한 시스템 구축에 협업할 계획이다.

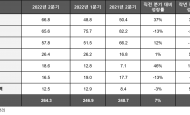

KT, 건사협과 지하 통신시설 보호 위해 협력양 기관은 공동 안전관리와 예방을 위한 기술 개발과 시범 적용에 상호 협력하기로 이번 협약을 통해 약속했다. KT는 우선적으로 건사협 회원이 지하 통신시설 매설 정보 확인을 위한 직통 채널을 공유하고, 협약 이후 건사협의 중장비 주변 KT 지하 통신시설 여부 확인을 위한 시스템 구축에 협업할 계획이다. 2분기/2022 전세계 반도체 장비 매출액 직전분기 대비 7% 상승SEMI의 최신 “반도체 장비시장통계 보고서(Worldwide Semiconductor Equipment Market Statistics, WWSEMS)”에 따르면 2022년 2분기 전 세계 반도체 장비 매출액은 직전 분기 대비 7% 성장한 264억 3천만 달러를 기록했다. 이는 작년 동기의 248억 7천만 달러 대비 6% 성장한 수치이다.

2분기/2022 전세계 반도체 장비 매출액 직전분기 대비 7% 상승SEMI의 최신 “반도체 장비시장통계 보고서(Worldwide Semiconductor Equipment Market Statistics, WWSEMS)”에 따르면 2022년 2분기 전 세계 반도체 장비 매출액은 직전 분기 대비 7% 성장한 264억 3천만 달러를 기록했다. 이는 작년 동기의 248억 7천만 달러 대비 6% 성장한 수치이다.

로지텍, 첫 60% 배열 게이밍 키보드 ‘PRO X 60 LIGHTSPEED’ 출시

로지텍, 첫 60% 배열 게이밍 키보드 ‘PRO X 60 LIGHTSPEED’ 출시 지멘스 Simcenter 솔루션, 이모터스의 e-드라이브 소음진동 테스트에 채택

지멘스 Simcenter 솔루션, 이모터스의 e-드라이브 소음진동 테스트에 채택 마이크로소프트, 국내 비즈니스 혁신 주도하는 AI 트랜스포메이션 사례 공개

마이크로소프트, 국내 비즈니스 혁신 주도하는 AI 트랜스포메이션 사례 공개 버티브, 인공지능 기능의 차세대 마이크로 모듈형 데이터센터 출시

버티브, 인공지능 기능의 차세대 마이크로 모듈형 데이터센터 출시 인섹시큐리티, 암호화폐 분석 디지털 포렌식 솔루션 'TRM 인텔리전스' 출시

인섹시큐리티, 암호화폐 분석 디지털 포렌식 솔루션 'TRM 인텔리전스' 출시

- 쿤텍, 자율주행차의 새로운 패러다임 SDV를 위한 실시간 하이퍼바이저 공급

- 인텔, 한스 촹 아시아 태평양 지역 총괄 선임

- 인텔 파운드리, 고개구율 극자외선(High-NA EUV) 도입으로 칩 제조 분야 선도

- NXP, 연간 기업 지속 가능성 보고서 - ESG 목표 달성 현황 공개

- 로데슈바르즈, 획기적인 성능으로 무장한 R&S NGC100 파워 서플라이 제품군 신규 출시

- IMDT와 Hailo가 합작하여 최고의 실시간 성능을 위한 엣지 AI 솔루션 출시

그래픽 / 영상

결정론, 새로운 이더넷 애플리케이션을 열다

결정론, 새로운 이더넷 애플리케이션을 열다 AMD, 새로운 2세대 버설 적응형 SoC로 AI 기반 임베디드 시스템의 종단간 가속 지원

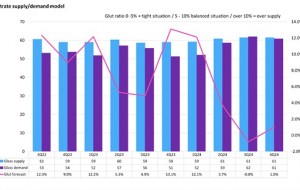

AMD, 새로운 2세대 버설 적응형 SoC로 AI 기반 임베디드 시스템의 종단간 가속 지원 2024년, 디스플레이 글래스 산업 공급부족 우려

2024년, 디스플레이 글래스 산업 공급부족 우려

많이 본 뉴스

콩가텍, COM-HPC 캐리어 설계 가이드 개정본 2.2 공개

콩가텍, COM-HPC 캐리어 설계 가이드 개정본 2.2 공개 KT, '커스터마이징EZ’로 중소기업 디지털 전환 촉진

KT, '커스터마이징EZ’로 중소기업 디지털 전환 촉진 피코콤, 웨이브 일렉트로닉스의 오픈랜 장비에 채택

피코콤, 웨이브 일렉트로닉스의 오픈랜 장비에 채택 키사이트, 스카일로 비지상 네트워크 인증 프로그램 주도

키사이트, 스카일로 비지상 네트워크 인증 프로그램 주도 ST, 실리콘 또는 GaN 컨버터의 효율성 높이는 동기식 정류기 컨트롤러 출시

ST, 실리콘 또는 GaN 컨버터의 효율성 높이는 동기식 정류기 컨트롤러 출시 인텔, 파운드리 사업 위한 재무 구조 개편 및 수익성 확대 방안 설정

인텔, 파운드리 사업 위한 재무 구조 개편 및 수익성 확대 방안 설정 테스트웍스, 6년 연속 데이터바우처 지원사업 공급기업 선정

테스트웍스, 6년 연속 데이터바우처 지원사업 공급기업 선정 마우저, 업계 선도 제조사들의 산업 자동화 제품 공급 확대

마우저, 업계 선도 제조사들의 산업 자동화 제품 공급 확대 ST, 최첨단 온칩 디지털 서명 갖춘 NFC 태그로 브랜드 보호 확대

ST, 최첨단 온칩 디지털 서명 갖춘 NFC 태그로 브랜드 보호 확대 마우저, ‘2024 미래를 여는 설계 콘테스트’ 후원

마우저, ‘2024 미래를 여는 설계 콘테스트’ 후원